Специалисты OpenAI разработали сразу две нейросети. Одна из них способна рисовать любые картинки по текстовому описанию, тогда как вторая может определять предметы и классифицировать их, полагаясь на описание.

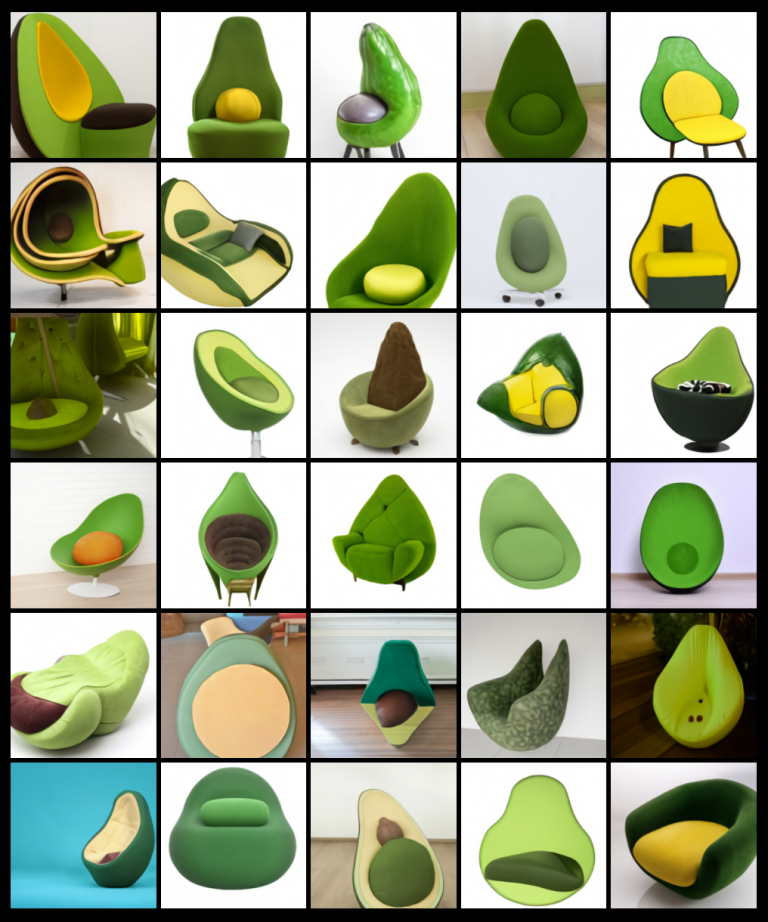

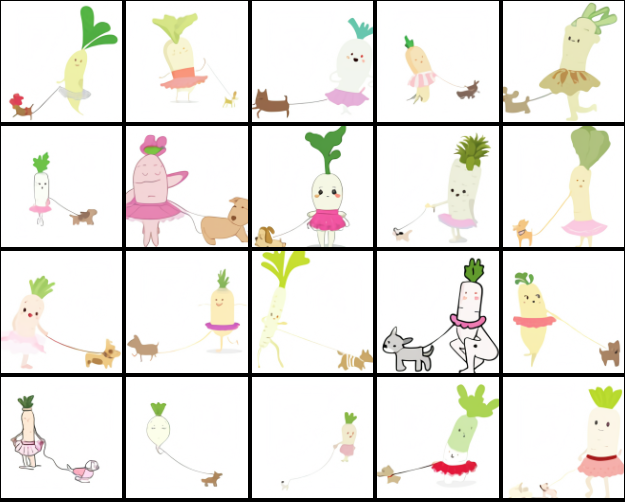

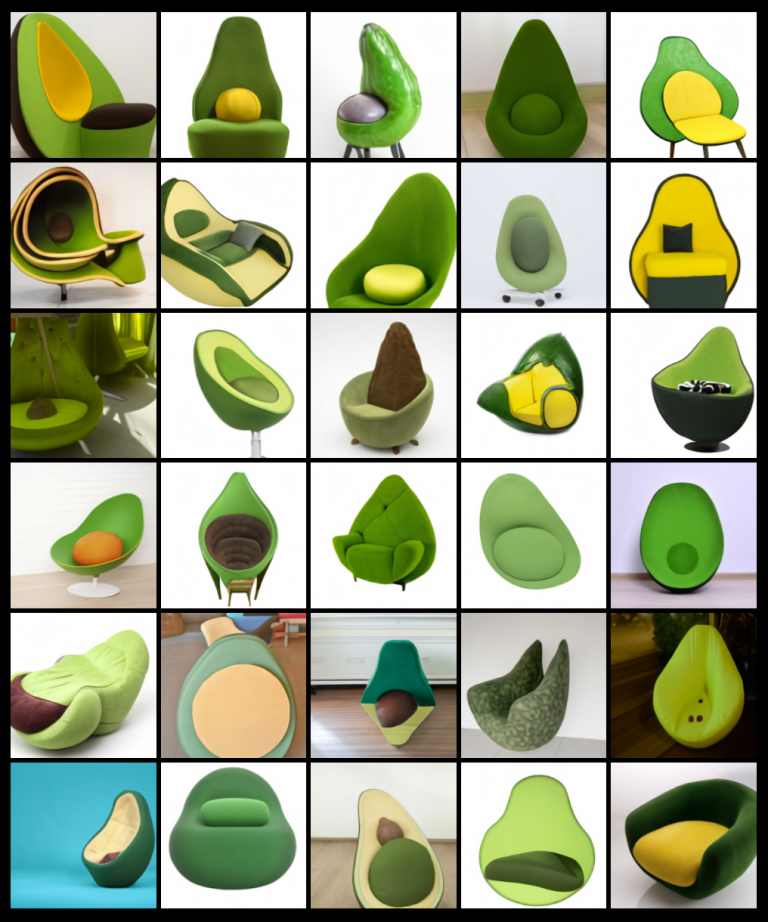

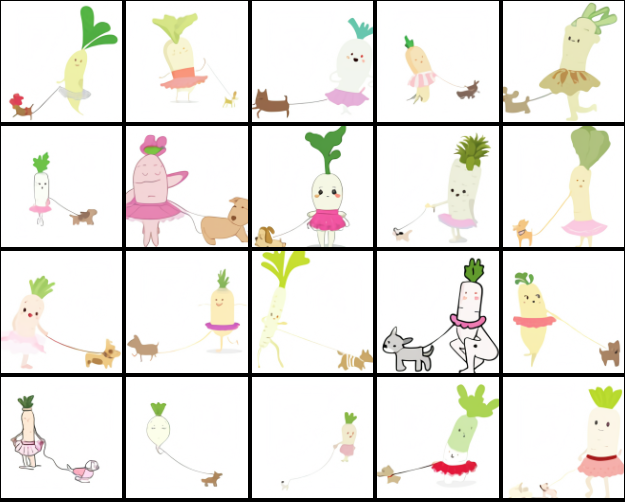

Нейросеть, которую обучили рисовать картинки по описанию, назвали DALL-E. Что интересно, компьютер не ищет по описанию изображения в интернете, а самостоятельно создает их. К примеру, вот что DALL-E выдает по запросу “кресло в форме авокадо”.

Однако стоит отметить, что все запросы необходимо вводить на английском языке, поскольку только его нейросеть способна обрабатывать.

Что касается второй нейросети, представленной OpenAI, ее назвали CLIP. Она предназначена для классификации картинки по описанию. К слову, описание должно быть на английском языке.